L’intelligence artificielle a connu ces dernières années des développements importants grâce aux progrès réalisés dans la mise en œuvre informatique de réseaux de neurones, capables d’un véritable apprentissage. Entraînés sur d’immenses bases de données et bénéficiant de l’augmentation considérable de la puissance de calcul, ces systèmes voient aujourd’hui leur champ d’application s’étendre : reconnaissance vocale, d’image ou d’écriture, véhicules autonomes, traitement du langage naturel, assistants personnels ou professionnels…

L’intelligence artificielle ira-t-elle jusqu’à supplanter l’homme, comme le suggèrent certains scénarios hollywoodiens ? Quels sont les bénéfices attendus du développement de cette discipline et de ses applications ? Quel sera l’impact de l’accélération actuelle du progrès sur la société, le travail et l’économie ? Autant de questions qui se posent aujourd’hui.

Mythes et réalités

L’intelligence artificielle fêtera cette année ses 60 ans. Cette discipline a été lancée en 1956 par deux jeunes étudiants, John McCarthy et Marvin Minsky. Leur projet initial : étudier l’intelligence en la décomposant en modules si élémentaires qu’une machine soit capable de les reproduire. L’intelligence artificielle a connu une période d’euphorie optimiste au cours des années 1960 : on espérait des progrès très rapides… Mais ce n’est pas ce qui s’est produit.

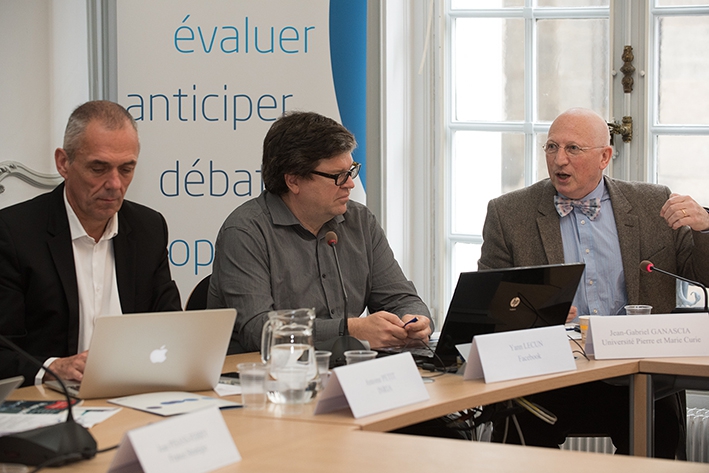

« C’est que l’intelligence est beaucoup plus complexe que ce que l’on pensai »t, explique Yann LeCun, directeur du laboratoire d’intelligence artificielle de Facebook (FAIR), professeur à l’université de New York (NYU) et titulaire en 2015-2016 de la chaire « Informatique et Sciences numériques » au Collège de France : « Des tâches que les animaux ou les humains réalisent sans effort et sans y penser, comme la perception visuelle ou auditive, requièrent une puissance de calcul énorme et sont très difficiles à reproduire par les ordinateurs. Le quart ou le tiers du cerveau humain est entièrement dédié à la vision. »

Ce décalage est également né de malentendus liés à l’ambivalence du concept d’intelligence artificielle, souligne Jean-Gabriel Ganascia, professeur à l’université Pierre-et-Marie-Curie et directeur de l’équipe Agents cognitifs et apprentissage symbolique automatique (ACASA) du laboratoire d’informatique (LIP6). « Cette discipline étudie l’intelligence avec des moyens artificiels… Mais en même temps, elle peut apparaître à tort, notamment dans les médias, comme la promesse, trop ambitieuse, d’une machine dotée d’une intelligence humaine, vue comme un double de nous-même. Un mythe ancien, remontant à l’Antiquité et réactualisé à chaque époque. Certains ont cru ainsi pouvoir affirmer que l’intelligence artificielle n’avait pas tenu toutes ses promesses, alors que c’est la discipline qui a le plus transformé la société au cours des soixante dernières années. Le web, couplage de l’hypertexte et des réseaux, c’est d’abord de l’intelligence artificielle. Nos téléphones portables sont également truffés d’applications issues de cette discipline comme la biométrie, la reconnaissance d’image et de la parole, la compréhension du langage, la recherche d’itinéraires. »

60 ans de progrès… et d’hivers

Au cours des années 1960, les efforts se sont concentrés sur la construction de machines intelligentes, dans une tentative de mécaniser les processus de pensée à partir de la logique et de la déduction. Mais ces méthodes se sont révélées inefficaces pour résoudre des problèmes comme la perception ou le contrôle. L’intelligence artificielle a alors connu une longue « hibernation » dans les années 1970, puis un regain dans les années 1980, suivi d’un nouvel « hiver » dans les années 1990. Jusque-là, peu de progrès sont apparus aux yeux du grand public, sauf dans certains domaines comme les jeux et notamment les échecs.

À la veille des années 2000, une « nouvelle vague » a déferlé avec l’arrivée de l’apprentissage automatique (machine learning) qui permet d’entraîner les machines à réaliser une tâche – et plus seulement de les programmer pour cette tâche. Des techniques utilisées notamment par les entreprises qui font de l’analyse de données et du big data comme les grandes compagnies de l’Internet, pour le tri et la recherche d’informations.

Depuis le début des années 2010, l’intelligence artificielle a bénéficié des progrès d’un nouvel ensemble de techniques, appelé l’apprentissage profond (deep learning), dont Yann LeCun a été l’un des précurseurs. Il consiste à appliquer l’apprentissage automatique à des tâches beaucoup plus complexes comme la reconnaissance d’image. « Nous avons maintenant des systèmes capables de reconnaître n’importe quel objet dans une image, de le localiser, de dessiner son contour, de reconnaître les visages, d’analyser l’expression des personnes, de savoir quelle action se déroule dans une vidéo », précise Yann LeCun.

« Il existe d’autres techniques comme l’apprentissage par renforcement, utilisé par le programme AlphaGo, victorieux en mars 2016 du meilleur joueur mondial de go : le système s’entraînait aussi en jouant contre lui-même, ajoute Jean-Gabriel Ganascia. Quant à l’apprentissage non supervisé, par lequel une machine, à l’image de l’homme ou de l’animal, serait capable, à partir du spectacle du monde, de construire elle-même des connaissances, des concepts, d’inventer des choses nouvelles, c’est l’un des grands défis de la recherche. »

Reconnaissance d’image et voiture autonome

Grâce à des machines dotées d’une très forte puissance de calcul et à la disponibilité de bases de données massives pour entraîner ces machines, l’une des techniques du deep learning, appelée les réseaux convolutifs, s’est généralisée pour la reconnaissance d’image et de la parole. Elle est utilisée dans la fonction de reconnaissance vocale des smartphones et par tous les systèmes de gestion de photos permettant d’analyser les images, de les grouper et de les indexer via la recherche par mots clés.

Aujourd’hui, les 1,6 milliard d’utilisateurs de Facebook postent chaque jour un milliard de photos. Chaque image est analysée par deux systèmes fondés sur les réseaux convolutifs. Le premier reconnaît les objets dans l’image et permet à Facebook de déterminer si une image est intéressante pour un utilisateur particulier : si celui-ci aime la voile et que l’un de ses amis poste une image de voilier, le système va lui montrer cette photo. Le deuxième porte sur la reconnaissance de visage : cette fonctionnalité, non activée en Europe, permet d’alerter les personnes figurant sur une photo publiée par un autre utilisateur.

Ces techniques de reconnaissance d’image vont se généraliser sur les téléphones portables, dans les voitures, dans les robots... Principale application actuelle : l’assistance à la conduite. La société Mobileye, par exemple, a développé un système de perception et de vision permettant à la voiture de se conduire toute seule sur l’autoroute, de détecter les obstacles, de changer de voie automatiquement... Un système déjà déployé dans des voitures haut de gamme comme les Tesla. « Ces systèmes vont se généraliser à toutes les gammes. D’ici dix à quinze ans, les automobiles vont devenir autonomes, affirme Yann LeCun. Et d’ici vingt à vingt-cinq ans, on peut même imaginer qu’il deviendra illégal pour une personne de conduire une voiture car l’humain ne sera pas aussi fiable que la machine. »

Autre domaine d’utilisation : l’analyse d’images médicales. Les premières expériences montrent que ces systèmes permettent d’augmenter la performance et la fiabilité dans la détection de tumeurs et de cancers. Une innovation qui devrait transformer le métier de radiologue et contribuer à améliorer la santé publique.

Dialoguer avec les assistants virtuels

Moins avancés, les systèmes de compréhension de la langue naturelle ont connu des progrès récents. Ils permettront d’indexer des textes et de concevoir des systèmes de traduction automatique très performants. D’ici cinq à dix ans, on devrait disposer de systèmes de questions / réponses et d’assistants virtuels capables de répondre à n’importe quelle question. Une avancée utile pour les médecins, qui bénéficieront d’un expert virtuel capable de les renseigner sur un sujet précis de la littérature scientifique et technique de leur domaine.

D’ici dix à vingt ans, il sera possible de dialoguer avec les assistants virtuels accessibles sur les smartphones. Aujourd’hui, Google Now, Siri et Cortana peuvent seulement répondre à des questions préprogrammées sous forme de règles par des humains, mais pas à des questions ouvertes ou non prévues par les concepteurs. D’ici une ou deux décennie(s), les assistants virtuels seront beaucoup plus « généraux », capables par exemple de négocier à notre place notre forfait de téléphone mobile avec l’opérateur ou de réserver un restaurant et d’inviter nos amis...

Aujourd’hui, le grand défi est de trouver des méthodes d’apprentissage non supervisé, qui permettraient à une machine de s’entraîner à partir de données brutes, sans qu’on lui donne les réponses à toutes les questions. « La résolution de ce problème scientifique prendra plusieurs décennies, estime Yann LeCun. Il s’agit d’entraîner les machines à acquérir « le sens commun », à comprendre les contraintes du monde. Quand on est bébé, on découvre que le monde est tridimensionnel, que lorsqu’un objet est caché derrière un autre, il est toujours là, que certains objets peuvent bouger et pas d’autres... Tout cela, on l’apprend parce que le cerveau humain est une machine à prédire. On ne sait pas encore faire de l’apprentissage prédictif non supervisé avec les ordinateurs. Et tant que l’on ne saura pas faire cela, on n’aura pas de machine vraiment intelligente. »

Vers une transformation des métiers

Les nouvelles applications de l’intelligence artificielle vont transformer l’accès au savoir et à l’économie. Certaines compétences intellectuelles seront « mécanisées » et d’autres vont gagner en valeur, notamment celles où les humains gardent un avantage certain sur les machines aussi loin que l’on puisse voir : les activités créatives et créatrices, l’art, la science et la technique, mais aussi toutes les activités liées aux relations entre les personnes...

« Dans les fantasmes, il y a toujours la peur que la machine remplace l’humain, mais dans les faits, c’est la combinaison homme / machine qui est la plus efficace et cela va probablement continuer dans le futur, assure Yann LeCun. Il ne faut pas voir l’apparition de machines intelligentes comme un remplacement, mais comme un levier de démultiplication de notre intelligence ».

« Le dépassement des métiers par la technologie n’est pas un phénomène nouveau. Je ne crois pas à une rupture qualitative qui bouleverserait d’un coup le marché du travail. Ce sera plutôt une accélération de transformations en marche depuis longtemps. Comme les richesses produites par personne vont augmenter, l’une des questions sera celle de la redistribution de ces richesses. L’enjeu sera aussi d’accompagner ces mutations technologiques par la formation et l’apprentissage continu. On ne peut pas écarter le risque d’un retournement d’une partie de la population contre la technologie et l’automatisation, comparable aux mouvements nés à la fin de la révolution industrielle, une forme de marxisme 2.0 ».

« Nous avons entendu des déclarations fracassantes du type « d’ici trente ans, 50 % des emplois vont disparaître ». Ces chiffres ne sont fondés sur aucune étude, confirme Jean-Gabriel Ganascia. La vraie question est celle de la transformation des métiers et de la mise en place d’une véritable formation tout au long de la vie. »

Les machines bientôt plus intelligentes que les humains ?

À long terme, existe-t-il un scénario possible à la Terminator dans lequel les machines deviendraient plus intelligentes que les humains, voire domineraient le monde et menaceraient l’humanité ? « Ce scénario reste très improbable et la technologie actuelle est très loin de pouvoir construire des machines « généralement intelligentes », explique Yann LeCun. Il faudra plusieurs décennies pour que les machines puissent atteindre un niveau d’intelligence générale comparable à celui des humains. La question sera de savoir comment construire ces machines pour que leurs pulsions, leur morale et leurs émotions soient en phase avec les valeurs humaines. Ce problème ne paraît pas si compliqué sur le plan conceptuel. Au-delà de considérations philosophiques et scientifiques, ce sera avant tout une question d’ingénierie. »

« Si les machines sont capables d’apprendre de leur propre expérience, il est possible qu’elles nous surprennent et nous déroutent, prévoit Jean-Gabriel Ganascia. Il existe des réflexions sur l’introduction de valeurs humaines dans les machines. La communication homme/machine représente un enjeu majeur : si nous voulons que les machines soient adaptées à nos besoins et qu’elles ne nous piègent pas, nous allons utiliser des techniques pour communiquer avec elles. La compréhension du langage et la reconnaissance de la parole jouent ici un rôle important, mais aussi la reconnaissance des émotions (affective computing), car l’échange avec une machine est plus facile et plus rapide si l’on se place sur le plan des émotions que si l’on utilise un langage abstrait. »

« Les perspectives singularistes – qui imaginent une rupture menaçant l’humanité – font l’objet d’annonces depuis 2015. Il s’agit de scénarios de science-fiction, malheureusement repris par certains scientifiques comme l’astrophysicien Stephen Hawking, souligne Jean-Gabriel Ganascia. On nous présente un scénario « plausible », populaire et effrayant. Mais celui-ci reste très improbable et ne repose pas sur des arguments scientifiques. Les fausses peurs du singularisme ne doivent pas masquer les vrais dangers, liés aux mutations des métiers, du travail et de la société .»